2021年8月上旬、Appleは児童虐待の画像が含まれる写真を検出する新システムを発表しました(英語記事)。児童ポルノの拡散に対処するというAppleの動機が善意から来ていることは明白に思われますが、今回の発表は瞬く間に非難の的となりました。

Appleは長年にわたり、利用者のプライバシーに配慮するデバイスメーカーというイメージを築いてきました。iOS 15とiPadOS 15への搭載が見込まれるこれら新機能によって、その評価には深刻な打撃が与えられましたが、同社は譲りません。この記事では、これまでの状況と、iPhoneやiPadを利用する平均的な人々への影響について説明します。

CSAM Detectionとは何か

Appleの計画の概要は、公式サイトに掲載されています(英語記事)。同社の開発した「CSAM Detection」というシステムは、利用者のデバイス上で「児童性的虐待コンテンツ」(Child Sexual Abuse Material:CSAM)を検索するシステムです。

「児童ポルノ」はCSAMと同じ意味ですが、米国の行方不明の子どもや搾取されている子どもの発見と救出を支援する全米行方不明・被搾取児童センター(NCMEC)は、「CSAM」の方が適切な用語だと考えています(リンク先は英語)。NCMECは、Appleなどのテクノロジー企業に、既知のCSAM画像に関する情報を提供しています。

AppleはCSAM Detectionと共に、Apple製モバイルデバイスのペアレンタルコントロールを拡張する機能をいくつか発表しました。例えば、性的に露骨な写真がApple の「メッセージ」アプリで子どもに送られてきたときに、保護者へ通知が行くようになります。

複数の技術が同時に発表されたことで多少の混乱が生じ、Appleは利用者全員を四六時中監視するつもりなのだと、多くの人が感じました。しかしそうではありません。

CSAM Detectionのロールアウト予定

CSAM Detectionは、iOS 15とiPadOS 15の一部として、対象のすべてのiPhoneとiPad(iPhone 6s以降と第5世代iPad以降)に今秋提供される予定です。理論上は、この機能を全世界のApple製モバイルデバイスで利用できますが、当面はフル機能を利用できるのは米国内のみです。

CSAM Detectionの仕組み

CSAM Detectionは、iCloudサービスの一部である「iCloud写真」と連携させないと機能しません。iCloud写真は、写真をスマートフォンやタブレットからAppleのサーバーにアップロードする機能で、アップロードすれば別のデバイスからも写真にアクセスできるようになります。

設定で写真の同期を無効にすると、CSAM Detectionは機能しなくなります。ということは、犯罪者データベース内の写真との比較が、クラウド上でしか行われないということなのでしょうか?そういうわけではありません。このシステムは、必要なレベルのプライバシーを保証するために、意図的に複雑になっています。

Appleの説明によると(英語)、CSAM Detectionはデバイス内の写真をスキャンして、NCMECやその他同様の組織のデータベース内の写真と一致するかどうかを調べます。

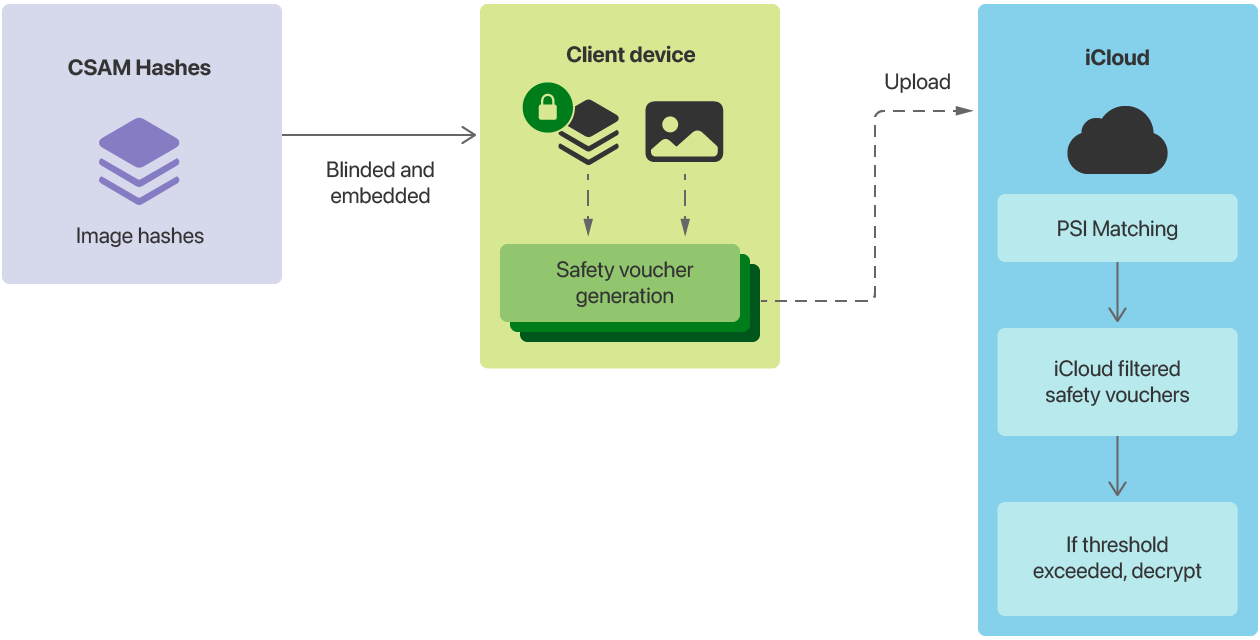

CSAM Detectionの仕組みの概略図。出典

その際に使用されるのは、写真の内容に基づいて写真のデジタルID(つまりハッシュ)を作成する、NeuralHashという技術です。児童の性的搾取画像のデータベース内にあるハッシュとの一致があった場合、画像とそのハッシュがAppleのサーバーにアップロードされます。Appleではもう一つチェックを実行してから、その画像を正式に登録します。

CSAM Detectionによるスキャンの結果は、Private Set Intersection(PSI)と呼ばれる暗号技術によって暗号化されます。そのためAppleは、一連の基準が満たされない限り、これを復号できません。これで理論上はシステムの悪用を防ぐことができる、つまり、従業員によるシステムの乱用や、政府機関の要請で画像が引き渡される事態を防止できるはずです。

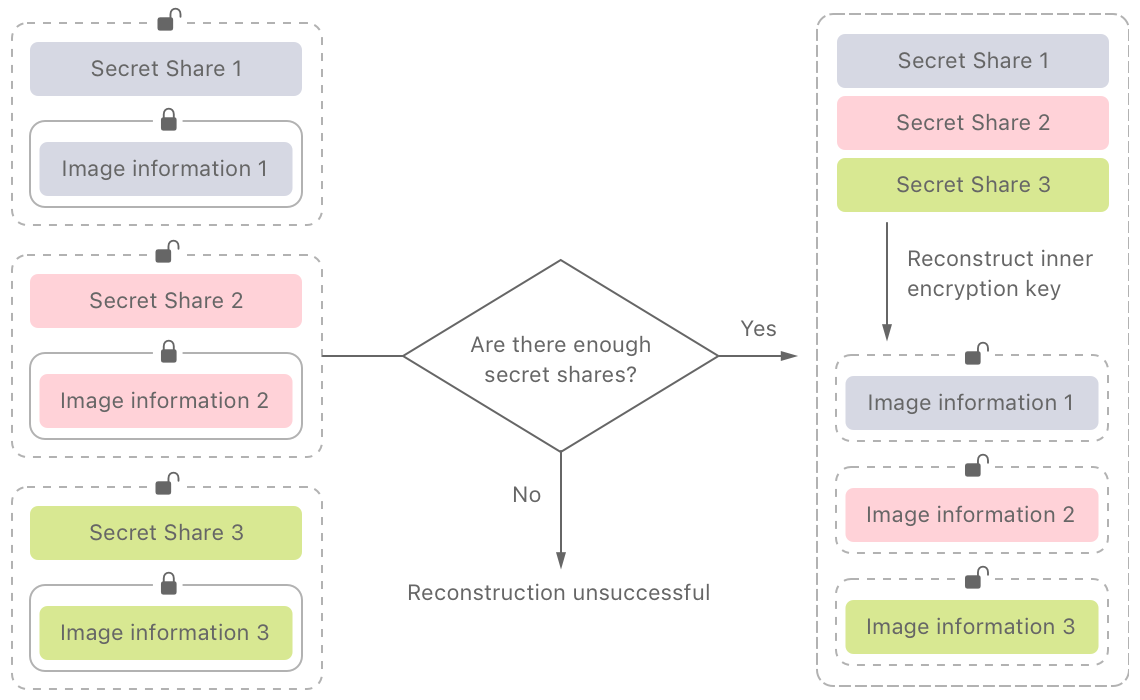

Appleのソフトウェアエンジニアリング担当シニアバイスプレジデントのクレイグ・フェデリギ(Craig Federighi)氏は、8月13日のWall Street Journalとのインタビューで、PSI プロトコルの主な安全機構について明言しました(英語記事)。Appleにアラートを出すには、30枚の写真がNCMECデータベースの画像と一致する必要があります。下図が示すとおり、そのしきい値に達するまでは、データセット(CSAM Detectionの動作と写真に関する情報)の復号が許可されません。Appleは、画像に関するアラートを出すためのしきい値が非常に高いため、誤合致の可能性は「1兆分の1の確率」と非常に低いとしています。

CSAM Detectionシステムの重要機能。データを復号するには、大量の写真が一致しなければならない。出典

アラートが出た場合はどうなるのでしょうか?その場合は、Apple社員が手動でデータをチェックし、児童ポルノの存在を確認し、当局に通報します。CSAM Detectionが完全に機能するのは、当面は米国内だけであるため、通報先は米司法省が支援するNCMECです。

CSAM Detectionの問題点

Appleの動きに対する批判は、2つに分類できます。同社のアプローチに対する疑問と、プロトコルの脆弱性に対する厳しい追及です。現時点で、Appleが技術的なミスをしたという具体的な証拠はほとんどありませんが(この件については後述)、全般的な不満は後を絶ちません。

例えば電子フロンティア財団(EFF)が、これらの問題を詳しく取り上げています(英語記事)。EFFは、利用者の側に画像スキャン機能を追加することで、Appleは事実上、デバイスにバックドアを仕込んでいるとしています。EFFは、2019年という早い時期からこのコンセプトを批判してきました(英語記事)。

何がよくないのか。デバイス内のデータが(Appleの主張どおり)完全に暗号化されていて、その内容について部外者への報告が始まると考えてみてください。現時点での報告対象は児童ポルノなので、「間違ったことをしていないなら、心配する必要はない」という話になります。しかし、このようなメカニズムが存在する限り、他のコンテンツに適用されないとは言い切れません。

突き詰めれば、これは技術的な批判というより政治的な批判です。問題は、セキュリティとプライバシーのバランスをとる社会契約が存在しないところにあります。官僚、デバイスのメーカー、ソフトウェア開発者、人権活動家、そして一般の人々と、あらゆる人がそのバランスを定義しようとしています。

法執行機関は、暗号化の普及によって証拠集めや犯罪者の逮捕が困難になったことに不満を漏らしていますが、確かに無理からぬことです。大規模なデジタル監視に関する懸念も明白です。このほか、Appleのポリシーや活動についてのものも含め、さまざまな意見があります。

CSAM Detectionの導入で考えられる問題

倫理面の懸念をやり過ごせば、技術面の困難が待ち受けています。どんなプログラムコードも、新たな脆弱性を生み出すものです。各国政府が何をするかもちろんですが、サイバー犯罪者にCSAM Detectionの脆弱性を使われたらどうなるのでしょうか?データの暗号化に関しては、この懸念も当然です。情報の保護を弱めたら、それが純然たる善意からであったとしても、誰でも脆弱性を別の目的に利用可能となってしまいます。

第三者機関によるCSAM Detectionのコードの監査は始まったばかりで、大いに時間がかかる可能性があります。しかし、すでにいくつかの点が明らかになっています。

まず、写真と「モデル」の比較を可能にするコードは、iOS(とmacOS)のバージョン14.3から存在していました(英語記事)。そのコードがCSAM Detectionの一部に使われることは、十分に考えられます。画像検索アルゴリズムを実験するためのツールによって、すでに衝突が見つかっています(リンク先は英語)。例えば、AppleのNeuralHashアルゴリズムによると、以下の2つの画像は同じハッシュを持っています。

AppleのNeuralHashアルゴリズムによれば、2枚の写真は一致している。出典

違法な写真のハッシュのデータベースを引き出すことができれば、アラートを出す「無害な」画像を作成可能になります。そうなると、Appleは誤ったアラートを大量に受け取って、CSAM Detectionを維持できなくなるかもしれません。おそらくこれが理由で、Appleは検知部分を分離し、アルゴリズムの一部をサーバーエンドでのみ機能させているのでしょう。

AppleのPrivate Set Intersectionプロトコルに関しては、こんな分析もあります(リンク先はいずれも英語)。要は、PSIシステムはアラートのしきい値に達する前でもかなりの情報をAppleのサーバーに転送する、という不満です。この記事は法執行機関がAppleのデータを要求した場合にどうなるかを説明しており、アラートが誤報であっても警察の関与する事態となる可能性が指摘されています。

今のところ、以上はCSAM Detectionの外部レビューにおける初期テストにすぎません。その成否は、秘密主義で有名な同社がCSAM Detectionの仕組みについて、特にソースコードに関して透明性を提示するかどうかに大きく左右されるでしょう。

一般の利用者に対するCSAM Detectionの影響

現代のデバイスは非常に複雑で、実際はどのくらい安全なのか(どの程度メーカーの言うとおりに機能するか)を突き止めるのは簡単ではありません。私たちのほとんどができることと言えば、同社を評判に基づいて信頼する(または疑う)ことくらいのものです。

しかし、CSAM Detectionは、利用者がiCloudに写真をアップロードした場合にしか動作しません。Appleの決定は慎重で、この技術への反発をある程度予期してのものでした。写真をクラウドにアップロードしなければ、何かをどこかに送信されることはありません。

2016年に勃発したAppleとFBIの対立(英語記事)をご記憶でしょうか。FBIがAppleに対し、カリフォルニア州サンバーナーディーノで発生した銃乱射事件の犯人が所有していたiPhone 5cのロック解除支援を要請した一件です。FBIは、iPhoneのパスワード保護を迂回できるソフトウェアの作成をAppleに求めました。

要請に従えば銃撃犯のiPhoneだけでなくすべての人のiPhoneがロック解除される可能性があることを認識していた同社は、これを拒否します。最終的にFBIは譲歩し、外部の協力を得てソフトウェアの脆弱性を突いてデバイスをハッキング(英語記事)、Appleは顧客の権利のために戦う企業という評判を守りました。

しかし、そこまで単純な話ではありません。Appleは、iCloudのデータのコピーを提出していました(英語記事)。同社は実際、iCloudにアップロードされたほぼすべての利用者データにアクセスできます。一部のデータ(キーチェーンのパスワードや決済情報など)はエンドツーエンドで暗号化されますが、大半の情報は不正アクセスからの保護、すなわち同社のサーバーへのハッキングから保護するためだけに暗号化されています。要するに、同社はデータを復号可能です。

その暗示するものは、CSAM Detectionの話の中で最も興味深い展開かもしれません。例えば同社は(FacebookやGoogleなど多数のクラウドサービスプロバイダーがやっているように)、iCloud写真内の全画像をスキャン可能かもしれません。Appleは、利用者を大規模に監視しているという非難をはねのけ得る見事なメカニズムを作り上げましたが、むしろ、利用者のデバイスを調査するというさらなる批判を招いています。

この騒動は、結局のところ、一般的な利用者に何か変化をもたらすわけではありません。自分のデータの保護について不安を覚えるなら、あらゆるクラウドサービスを疑問視するべきです。自分のデバイス上にしかないデータについては、今もなお安全です。Appleの最近の動きは、十分な根拠のある疑念を植え付けました。同社はこの方向に進み続けるのか、答えはまだ出ていません。

iOS

iOS

ヒント

ヒント